「その文章、本当に人間が書いたの?」AI文章の見抜き方とは

[最終更新日]2025/12/21

最近、社内のレポートやメールを読んでいて、「この文章、不自然なくらい流暢にまとまってない?」と感じたことはありませんか。

ChatGPTをはじめとする生成AIのおかげで、誰でもそれっぽい文章を一瞬で作れるようになりました。

ですが、その一方で、「この文章は本人の言葉なのか?」「中身は本当に信用していいのか?」という、新しい悩みも生まれています。

目次

1)なぜ、AIが書いた文章だとNGなのか?

まずは、「なぜ私たちは、文章がAIによるものかどうかに、こんなにも敏感になるのか」から考えてみましょう。

ここで一度、「ラクをしている」「AIに書かせて自分はサボっている」といった理由は脇に置いておきます。

たとえ本当にAI任せだったとしても、その文章が本人のものと同じクオリティ・中身であれば、本来そこまでナーバスになる必要はないはずです。

「この文章をAIに書かせたらNG」となるのは、大きく以下の3点が挙げられるでしょう。

- 間違いの許されない、正確な情報の文章が求められているとき

- コンプライアンスや情報管理の責任が伴うとき

- その人の考え方や個性が求められているとき

間違いの許されない、正確な情報の文章が求められているとき

生成AIには、ときどきもっともらしい誤情報を平然と出してしまう「ハルシネーション」という問題があります。

法律や医療、安全に関する案内、契約文書、社内規程など、事実のズレがそのままリスクにつながる文章をAIの書いたままノーチェックで使うことは避けるべきです。

一方で、AIにドラフトを書かせ、その後に人が出典確認や数字のチェックをきちんと行うのであれば、大きな問題にはなることは少ないでしょう。

このケースでNGとなるのは、「AIに書かせたこと」そのものではなく、「人の最終チェックがない状態で外に出してしまうこと」です。

コンプライアンスや情報管理の責任が伴うとき

ChatGPT や Gemini、Claude などの生成AIは、すべて外部サーバー上で動くサービスです。つまり、こちらが入力した文章は、一度必ず外部のサーバーに送られて処理されます。

最近は「入力内容を学習に使わない設定」や商用向けの「学習不使用プラン」もありますが、ここで押さえておくべきなのは、“学習に使われない=安全” ではないという点です。

学習に利用しない設定にしても、データ自体は外部に送られるため、システム障害や仕様変更、利用者側の設定ミスなどによって、情報が漏れる可能性を完全に排除することはできません。

そのため、社内の機密情報をそのまま生成AIに貼り付けて文章を作らせる行為は、一般的に望ましくなく、多くの企業で明確に禁止されています。

その人の考え方や個性が求められているとき

そして最も重要なのが、このポイントです。自己PRや評価シート、上司としての方針メッセージ、メンバーへのフィードバック、あるいは顧客との関係づくりにつながるメールなどでは、文章そのものよりも 「その人が何をどう考えているのか」「どんな言葉を選ぶ人なのか」 が重視されます。

ここをほとんどAIに任せてしまうと、文章は整っていても、その人らしさや判断の軸が伝わらなくなります。

たとえば、あなたが丁寧に考えて書いたメールに、相手がAIで一瞬で作った返信を返してきたとしたら、どこか距離を感じてしまうはずです。人は言葉を通じて、相手の真剣さや価値観を感じ取るからです。

「誰が書いても同じでいい文章なのか」

「あなたがどう書くかが意味を持つ文章なのか」

この違いこそが、AIに任せてよいかどうかを判断する際の、最も重視すべき基準なのではないでしょうか。

エピソード|クラウドサービスに「体験談」を募集した結果…

ここでひとつ、私の実体験をご紹介します。

「上司とのコミュニケーション」をテーマにしたレポート作成のため、国内大手のクラウドサービスを使い、数十名に「上司から受けた困った対応と、その対策」についての体験談を募集しました。

ところが、届いた文章の 約7割が“おそらくAIで作られたもの” だと感じざるを得ない内容だったのです。そう判断した理由は明確でした。

それらの体験談は、誤字脱字ひとつなく整った文章でありながら、状況説明がどれも微妙に不自然。そして何より、上司の行動から解決策までの流れが、こちらが事前に提示した例文とほぼ同じ展開を辿っていたのです。まるで、例文の様々な「言い換え」バージョンを眺めているような印象でした。もし私たちがそれに気づかないまま、「最近はこうしたケースが多いようです」とレポートにまとめて発信していたら——、誤った情報を広め、結果的に読者を「騙す」ことになっていたでしょう。

問題の本質は、「AIが作る体験談の質がイマイチなこと」ではありません。

本来なら自分の言葉で書くべき内容を、私たちは安易に、そして悪気もなくAIに任せてしまうことがあるという事実です。人がやった方がよいことまで、AIに預けてしまう──。そのようなケースは、私たちが意識して線引きをしていかない限り、今後ますます増えていくかもしれません。

2)「AIが書いたかも?」と感じる典型的なサイン

ここからは、「もしかしてAIが書いた文章かな?」と感じたときに、最初にチェックしたいポイントを見ていきましょう。

※注意点

ここで紹介するのは、あくまで“目安”にすぎません。これだけを根拠に「絶対AIで書いている」と決めつけることはできませんし、証拠もないまま相手に「これAIでしょ?」と指摘すると、関係性が悪くなる恐れもあります。文章の質や、どういうプロセスで作られたのかを話し合うためのヒントとして使ってください。

接続詞と次の文章が微妙に合わない

AIは「しかし」「一方で」「そのため」「結果として」「結論として」などの接続詞や、つなぎのフレーズをとても上手に、そして頻繁に使います。実際、ChatGPTが好んで使う接続詞や論文っぽい語が一覧でまとめられている記事もあるくらいです。

その結果、一見するとロジカルで読みやすい文章に見えるのですが、よく読むと接続詞と中身が微妙に噛み合っていないことが少なくありません。たとえば「しかし」と書いてあるのに前の文とほとんど対立していなかったり、「そのため」と言いつつ因果関係が弱かったりするパターンです。

レビューするときは、接続詞のところで一度立ち止まり、「本当にここは“しかし”なのか?」「“そのため”と言えるだけの理由が前に書かれているか?」と確認してみると、AI特有の“つなぎの違和感”に気づきやすくなります。

参考文献

・Words and Phrases that Make it Obvious You Used ChatGPT(Medium)

・27 words and phrases that make it obvious you used ChatGPT(ITP)

まとめの一文だけ、やたら壮大になる

もうひとつ、AI文章で「あるある」なのが、最後の一文だけ妙に壮大・抽象的になるパターンです。本文では具体的に話していたのに、締めくくりだけ

「私たちは今、その転換点に立っているのです」

「一人で抱え込まなくても絶対大丈夫です。自信を持って生きてください」

「世界が少しだけ軽くなる瞬間が必ずあります」

といった、超越した第三者の視点めいたフレーズになるケースです。

実際、「In conclusion」「Let’s delve into」といった“ChatGPTっぽい決まり文句”をまとめた記事も複数出ており、AIが好む定型的な締めフレーズが指摘されています。

本文の具体度と、最後の一文のスケール感がかけ離れていないか。「この一文だけ、やたら大きな話になっていないか」を見るのも、AIっぽさを見抜くときの一つのポイントです。

参考文献

・14 phrases that make it obvious you used ChatGPT(YourTango)

・These Phrases Tell Readers You Used ChatGPT(Evolve Media)

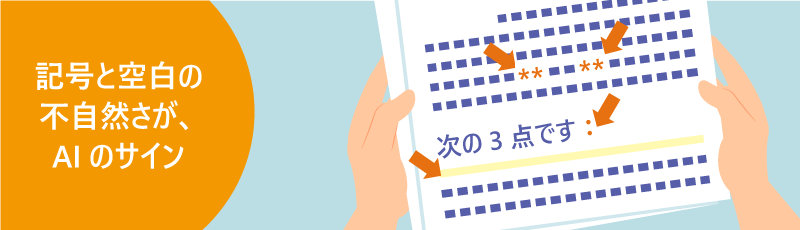

不自然な位置に「:」や「*」、空白スペースがある

次に分かりやすいサインが、記号やスペースの不自然さです。ChatGPT を含む多くの生成AIは、もともと 太字 や 箇条書き といった Markdown(マークダウン)形式で文章を出力するよう設計されています。そのため、そのままコピペされると次のような「名残」が残りがちです。

- 「次の3点です:」のように、文末にコロン(:)がやたら付く

- 「**重要なポイントです**」など、「**」や「*」がそのまま混ざっている

- 句読点の前後に意味のない半角スペースが入っている

- 段落の途中で不自然な改行や空白行が挟まっている

人間でもミスはしますが、普段の社内文書ではあまり見ない記号や空白のクセが急に増えたときは、「AIからのコピペかも?」と一度疑ってみる価値があります。

とくに、普段その人があまり使わない記号やレイアウトで急に文章がそろっている場合は、サインの一つと捉えてよいでしょう。

参考文献

・Wikipedia: Signs of AI writing

・Wikipedia’s guide on signs of AI writing(Mediumダイジェスト)

因果関係が浅い/つながりがガタついている

そして特に注意したいのが、因果関係の浅さや、話のつながりのガタつきです。ChatGPTやGeminiに代表される大規模言語モデル(LLM)は、「それっぽい説明」を並べるのは得意な一方で、複雑な因果関係を一貫して扱うのは苦手だと、多くの研究や技術ブログで指摘されています。

具体的には、こんな違和感として表に出ます。

- 原因と結果の向きがおかしい(例:「キャンペーンを実施した。その後、売り上げは下降した」など)

- Aの話をしていたのに、急にCに飛んでいて、中間のBが説明されていない

- 1つ前の段落と今の段落の主張が、さりげなく矛盾している

文章全体を読み終えたときに、「結局なぜこの結論になるのか」がスッキリしないなら、AI特有の“浅い因果”が入り込んでいるかもしれません。

そんな違和感を覚えたら、「この結論に至るまでのステップを、もう一度説明してもらえますか?」と、書き手にプロセスを確認してみるとよいでしょう。

参考文献

・Evaluating Causal Reasoning Capabilities of Large Language Models(MDPI Electronics)

・Unveiling Causal Reasoning in Large Language Models(arXiv)

・The Limitations of AI’s Causal Reasoning(Cloud Awards)

3)「AI検出ツール」を知っておこう

ここまで見てきた「文章のクセ」を手掛かりにした見分け方に加えて、仕事上どうしても「AIの文章かどうか」を頻繁に確認する必要がある立場の人は、AI検出ツールも押さえておくと便利です。

もちろん精度は完璧ではありませんが、「怪しさの度合いをざっくり把握するレーダー」としては有効でしょう。ここでは代表的なツールを2つ、紹介します。

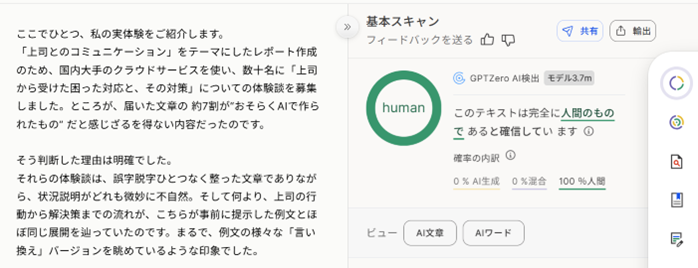

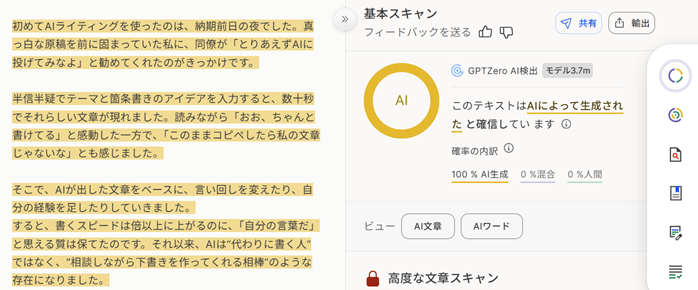

GPTzero

サイトURL:https://app.gptzero.me/

GPTZero は、教育現場やライティング業界でよく名前が挙がるAI検出ツールです。テキストを貼り付けたりファイルをアップロードしたりすると、その文章が「AIらしいか/人間らしいか」をスコアやハイライト付きで表示してくれます。

参考1:人が書いた文章を確認したとき

参考2:AIに書かせた文章を確認したとき

※ChatGPTに「AIライティングに関する体験談を500字程で作成して」と指示して作成した文章

もともとは、プリンストン大学の学生だったエドワード・ティアン氏が、学術分野でのAI生成テキストの不正利用を懸念して開発した個人プロジェクトから始まりました。現在では独立した企業として運営されており、その精度の高さから世界中で利用されています。

無料プランでもある程度の文字数までは利用でき、有料プランではGoogleドキュメントと連携して「書きながらリアルタイムでAI度をチェックする」機能なども使えます。

ただし、どれだけ精度が高くても「人間が書いた文をAIと誤判定する可能性」はゼロではないため、ツールの結果はあくまで“参考情報”として扱うようにしましょう。

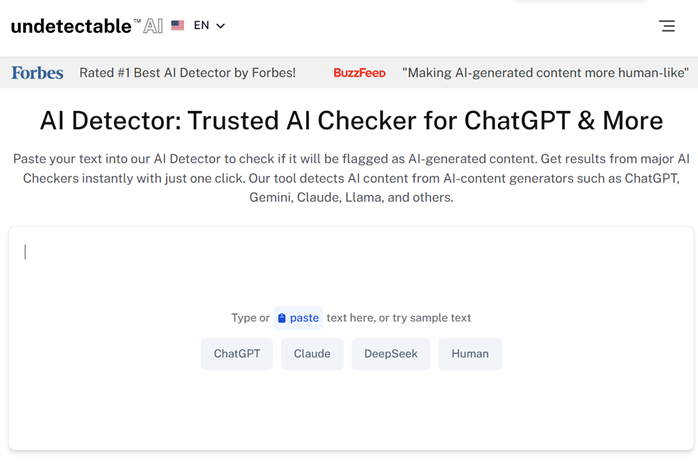

Undetectable.ai

サイトURL:https://undetectable.ai/

Undetectable.ai は、少し毛色の違うサービスです。ひとつは複数のAIチェッカーの結果をまとめて表示する検出機能。そしてもうひとつの大きな特徴が、AI文章を“人間っぽく書き換える(Humanize)”機能です。

AIが生成したテキストを再加工し、各種AI検出ツールから「人間が書いた文章」と判定されやすい形に整えてしまうというものです。

ここで見えてくるのは、まさに「いたちごっこ」の構図です。AIっぽさを暴こうとするツールがあれば、そのAIらしさを隠そうとするツールも生まれる──という状況になっています。

繰り返しになりますが、こうしたサービスは便利ではあるものの「万能」ではありません。

最終的な判断は、文脈や因果関係、そして書き手のプロセスを人の目で確かめることが重要であることを意識しておきましょう。

まとめ)「AIかどうか」だけでなく「人が書くことの大切さ」も伝えていこう

生成AIが広く使われるようになった今、世の中の情報のかなりの部分はすでにAIによる文章で占められつつあり、「人間が自分で書いた文章」の割合は少しずつ小さくなっています。

一方で、誰かが時間をかけて自分の言葉で書いた文章には、その人の経験や迷い、思いがにじみます。そうしたものは、これから先、むしろ希少な価値として扱われていくのかもしれません。

だからこそ、本当に大事なのは「AIを見抜く力」そのものではなく、人が自分の言葉で書くことの大切さと、その影響の大きさを、私たち自身が理解しておくことです。

もちろん、AIの優れた文章生成能力を「使ってはいけない」という話ではありません。

大切なのは、どこまでをAIに手伝ってもらい、どこからを自分の言葉として引き受けるのかという線引きを、一人ひとりが意識して考え続けること。

その態度自体が、これからの社会人に求められる姿勢なのではないでしょうか。